Marcel Waldvogel · @marcel

776 followers · 452 posts · Server waldvogel.familyIch wollte schon immer mal wissen, ob ich die Resultate von #Karpathy mit #nanoGPT und #Shakespeare auch auf deutsch reproduzieren könne. Gestern Abend habe ich den Versuch in die Tat umgesetzt und der Rechner hat die Nacht durch #Goethe gebüffelt, bis er seinen Stil nachahmen konnte. (Es ist ein sehr kleines Modell, deshalb ist "nachahmen" sehr grosszügig zu interpretieren…)

#ChatGPT am Beispiel von nanoGPT erklärt:

https://dnip.ch/2023/01/30/wie-funktioniert-eigentlich-chatgpt/

#karpathy #nanogpt #shakespeare #goethe #chatgpt

Marcel Waldvogel · @marcel

776 followers · 451 posts · Server waldvogel.family#Goethe oder #GPThe, äh, #GPT?

Ein kleines Experiment, ob man mit #nanoGPT nicht nur #Shakespeare-ähnliche #KI-Texte in Englisch generieren lassen kann, sondern ob auch Goethe-ähnliche in Deutsch möglich sind.

Die kurze Antwort: Ja. Und wenn es mit sehr viel Pathos auf der Bühne vorgetragen wird, dauert es möglicherweise einige Sätze, bis das Publikum das Problem erkennt. #ChatGPT

https://marcel-waldvogel.ch/2023/06/03/goethe-oder-gpthe/

#goethe #gpthe #gpt #nanogpt #shakespeare #ki #chatgpt

Marcel Waldvogel · @marcel

655 followers · 769 posts · Server waldvogel.familyDie KI #nanoGPT beginnt ganz, ganz einfach: Sie lernt aus dem #Shakespeare-Korpus die Häufigkeit, mit der ein Zeichen auf ein anderes folgt. Nach einem T kommt am häufigsten ein H, manchmal aber auch ein I oder E etc.

Nur aufgrund dieser Häufigkeiten dieser Information produziert unser erster Schritt Richtung #ChatGPT nun Output, der schon etwas an Text erinnert: Es hat Wortstrukturen, aber noch kaum englische Wörter. Definitiv noch kein Shakespeare-Plagiat!

https://dnip.ch/2023/01/30/wie-funktioniert-eigentlich-chatgpt/

#nanogpt #shakespeare #chatgpt

Marcel Waldvogel · @marcel

655 followers · 768 posts · Server waldvogel.family2️⃣ Wir bauen uns den kleinen Bruder von #ChatGPT, #nanoGPT

Andrej #Karpathy hat ein für einschlägig sehr gut Vorgebildete ein eindrückliches 2h-Video gedreht, in dem er vor den Augen der Zuschauer diesen kleinen Bruder programmiert.

Dieser Thread und mein Artikel sind der Versuch, dies auch für Nicht-Techies zu erklären.

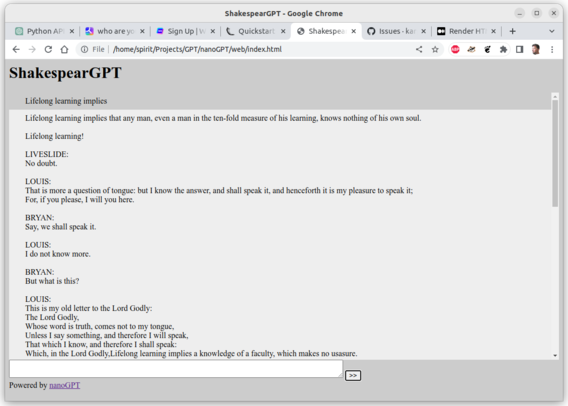

Rene K. Mueller XYZdims.com · @xyzdims

11 followers · 13 posts · Server mastodon.socialThere is #nanoGPT https://github.com/karpathy/nanoGPT to play with concepts of #GPT on your computer, trained it with Shakespeare's texts gives already beautiful completions.

Tommi Somersuo · @tsomersu

56 followers · 35 posts · Server infosec.exchangeAndrej Karpathy: Let's build GPT: from scratch, in code, spelled out.

"We build a Generatively Pretrained Transformer (GPT), following the paper "Attention is All You Need" and OpenAI's GPT-2 / GPT-3. We talk about connections to ChatGPT, which has taken the world by storm. We watch GitHub Copilot, itself a GPT, help us write a GPT (meta :D!) . I recommend people watch the earlier makemore videos to get comfortable with the autoregressive language modeling framework and basics of tensors and PyTorch nn, which we take for granted in this video."

#chatgpt #gpt #pytorch #nanogpt

rhgrouls :julia: · @rhgrouls

213 followers · 388 posts · Server fosstodon.org#nanoGPT reproduces #GPT-2 (124M) on OpenWebText, running on a single 8XA100 40GB node in 38 hours of training.

#nanogpt #gpt #chatgpt #machinelearning #artificialintelligence