ktp_programming · @ktp_programming

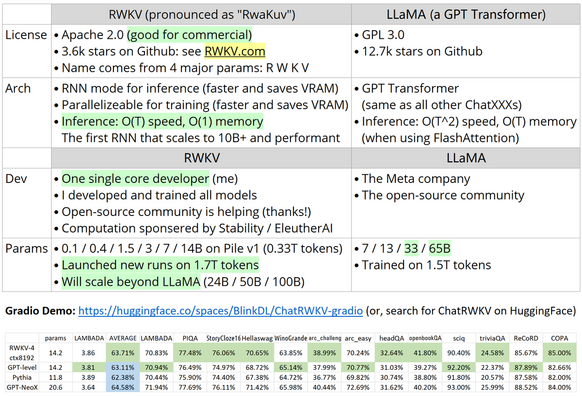

9 followers · 129 posts · Server piaille.fr#RWKV à mon sens, est potentiellement une nouvelle voie en termes de modèles de langage. On en parle peu parce qu'un étudiant chinois fait moins de marketing qu'une boite de la SV, mais son modèle permet des performances incroyables pour sa taille, et met le fine-tuning à portée de machines plus modestes. Et le fine-tuning, on le sait, amène de meilleures perfs que le zero-shot à la ChatGPT.

smashmaster0045 · @smashmaster

6 followers · 137 posts · Server mastodon.gamedev.placeRT @BlinkDL_AI

Raven v8🐦14B to the moon🚀based on #RWKV (100% #RNN language model) 14B/7B/3B/1B Download: https://huggingface.co/BlinkDL/rwkv-4-raven And v9 soon (ctxlen 8192, 3x SFT data)🚀

smashmaster0045 · @smashmaster

5 followers · 110 posts · Server mastodon.gamedev.placeRT @BlinkDL_AI

#RWKV is One Dev's Journey to Dethrone GPT Transformers. The largest RNN ever (up to 14B). Parallelizable. Faster inference & training. Supports INT8/4. No KV cache. 3 years of hard work. DEMO: https://huggingface.co/spaces/BlinkDL/ChatRWKV-gradio Computation sponsored by @StabilityAI @AiEleuther @EMostaque